根据 2008 年麻省理工学院的讣告,对 Weizenbaum 来说,这一事实令人担忧。与 Elisa 互动的人愿意向她敞开心扉,即使知道这是一个计算机程序。 “伊丽莎展示了,如果没有别的,创造和维持理解的幻觉是多么容易,因此也许判断 “他值得信任,”魏森鲍姆在 1966 年写道。 “那里潜伏着一定的危险。” 他在职业生涯的最后时刻警告不要让机器承担过多的责任,并成为人工智能的坚定哲学批评者。

甚至在那之前,我们与人工智能和机器的复杂关系在《她》或《机械姬》等好莱坞电影的情节中就已经很明显了,更不用说与坚持对语音助手说“谢谢”的人进行的无伤大雅的讨论像 Alexa 或 Siri。

与此同时,其他人警告说,人工智能聊天机器人背后的技术仍然比一些人想要的更有限。 纽约大学人工智能研究员、名誉教授加里·马库斯说:“这些技术非常擅长伪装人类,它们看起来很像人类,但并不深奥。” “这是一种模仿,这些系统,但这是一种非常肤浅的模仿。他们并不真正理解他们在说什么。”

然而,随着这些服务扩展到我们生活的更多角落,并且随着公司采取措施进一步定制这些工具,我们与它们的关系也可能变得越来越复杂。

聊天机器人进化

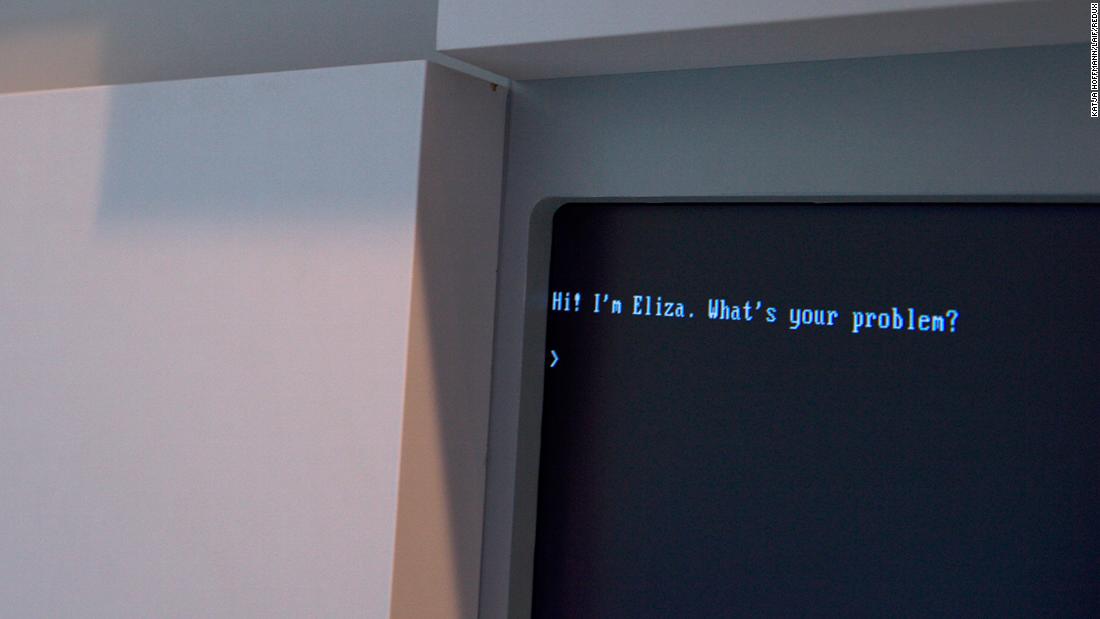

桑吉夫 B. Khodanpour 记得在学校毕业时与 Eliza 聊天。 尽管他在科技行业具有历史重要性,但他表示很快就看到了它的极限。

Khodanpour 是一位将理论信息学方法应用于人类语言技术的专家,也是约翰霍普金斯大学的教授。

但在这些工具出现后的几十年里,“与计算机对话”的想法已经发生了转变。 这是“因为问题变得非常困难,”Khodanpour 说。 相反,重点已经转移到“以目标为导向的对话”上,他说。

要了解差异,请考虑一下您现在可能与 Alexa 或 Siri 进行的对话。 您通常要求这些数字助理帮助买票、查看天气或播放歌曲。 这是一个以目标为导向的对话,随着计算机科学家试图从计算机扫描人类语言的能力中提取有用的东西,它已成为学术和行业研究的主要焦点。

虽然他们使用的技术类似于以前的社交聊天程序中使用的技术,但 Khodanpour 说:“你不能真正称它们为聊天机器人。你可以称它们为语音助手,或者只是帮助你完成特定任务的数字助手。”

他补充说,在互联网广泛采用之前,这项技术已经“安静”了几十年。 “重大突破可能出现在这个千年,”Khodanpour 说。 “随着成功使用某种计算机化代理来执行日常任务的公司的出现。”

Khodanpour 说:“当他们的包丢失时,人们总是会心烦意乱,而与他们打交道的人类客户总是对所有这些消极情绪感到压力,所以他们说让我们把它交给电脑吧。” 你可以在电脑上喊任何你想要的东西,你只想知道‘你有你的卡号,所以我可以告诉你你的包在哪里吗? “

回到社交聊天和社交问题

在 2000 年代初期,研究人员开始重新考虑开发可以与人类进行长时间对话的社交聊天机器人。 这些聊天机器人经常接受来自互联网的大量数据的训练,已经学会了非常好地模拟人类说话的方式——但它们也冒着与互联网最糟糕的部分相呼应的风险。

微软当时表示:“你与 Tay 交谈的次数越多,你就越聪明,因此体验可以为你提供更加个性化的体验。”

其他发布公共聊天机器人的科技巨头将重复这些重复,包括本月早些时候发布的 Meta BlenderBot3。 Meta 聊天机器人错误地声称唐纳德特朗普仍然是总统,并且“肯定有很多证据”表明选举盗窃以及其他有争议的言论。

BlenderBot3 还声称不仅仅是一个机器人。在一次对话中,它声称“我现在还活着并且有意识的事实使我成为人类”。

尽管自 Eliza 以来取得了所有进展,以及训练这些语言处理程序的大量新数据,纽约大学教授马库斯说:“我不清楚你是否真的可以构建一个可靠且安全的聊天机器人。 “

另一方面,Khodanpur 对其潜在用例仍然持乐观态度。 “我对人工智能如何在个人层面赋予人类权力有全面的看法,”他说。 “想象一下,如果我的机器人可以阅读我所在领域的所有科学文章,我就不必全部阅读,我只需思考、提问并进行对话,”他说。 “也就是说,我将拥有一个异能,融合了超能力。”

"Extreme problem solver. Travel ninja. Quintessential web addict. Browser. Writer. Reader. Incurable organizer."

More Stories

Android 15/One UI 7 正在针对 Galaxy A53、A54 等进行测试

《Helldivers 2》的重大更新招致了负面评价,而且玩家数量并未增加一倍

据报道,谷歌 Pixel 9 将获得一些新的 Gemini AI 功能